Podle odborníků byl nedostatek výpočetního výkonu v uplynulém roce hlavní překážkou pokroku v oblasti umělé inteligence, která brání nasazení stávajících modelů umělé inteligence a zpomaluje vývoj nových. Na vině je do značné míry nedostatek výkonných grafických procesorů, které akcelerují AI modely. Jedním ze způsobů, jak zmírnit výpočetní překážku, je vyrábět více čipů, ale lze také vyrábět výkonnější čipy AI.

Díky tomuto druhému přístupu může být H200 atraktivním produktem pro poskytovatele cloudových služeb. Grafický procesor H200 je pokračovatelem GPU H100, který byl uveden na trh v loňském roce, dříve nejvýkonnějším GPU čipem Nvidie pro umělou inteligenci.

Navzdory písmenu "G" v názvu "GPU" nejsou grafické procesory pro datová centra obvykle určeny pro grafiku. Jsou ideální pro aplikace umělé inteligence, protože provádějí obrovské množství paralelních výpočtů, které jsou nezbytné pro fungování neuronových sítí. Jsou nezbytné v tréninkové části sestavování modelu AI a v části "inference", kdy lidé zadávají vstupy do modelu AI a ten vrací výsledky.

Například společnost OpenAI opakovaně uvedla, že má málo GPU, což způsobuje zpomalení ChatGPT. Společnost se musí spoléhat na omezování rychlosti, aby vůbec mohla poskytovat nějaké služby. Hypoteticky by použití H200 mohlo dát stávajícím jazykovým modelům umělé inteligence, na kterých ChatGPT běží, více prostoru pro obsluhu většího počtu zákazníků.

Rychlejší GPU i paměť

Podle Nvidie je H200 prvním grafickým procesorem, který využívá paměť HBM3e. Díky HBM3e nabízí H200 141 GB paměti s propustností 4,8 terabajtu za sekundu, což je podle Nvidie 2,4násobek propustnosti paměti Nvidia A100 vydané v roce 2020.

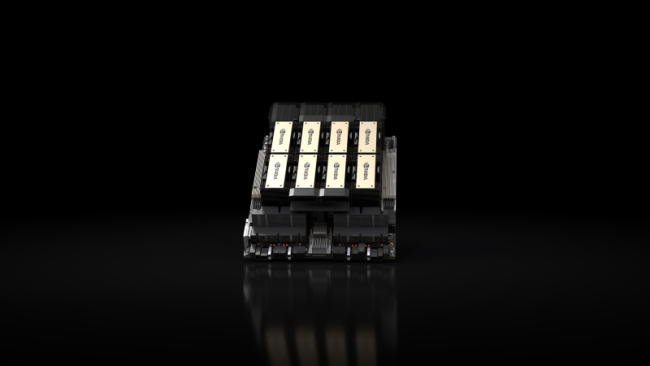

Nvidia bude H200 dodávat v několika formách. Patří mezi ně serverové desky Nvidia HGX H200 v konfiguraci s čtyřmi a osmi GPU, kompatibilní s hardwarem i softwarem systémů HGX H100. K dispozici bude také superčip Nvidia GH200 Grace Hopper, který kombinuje CPU a GPU do jednoho balíčku pro ještě větší sílu umělé inteligence.

„Aby bylo možné vytvořit inteligenci s generativními AI a HPC aplikacemi, musí být obrovské množství dat efektivně zpracováno vysokou rychlostí pomocí velké a rychlé GPU paměti,“ řekl Ian Buck, viceprezident hyperscale a HPC ve společnosti NVIDIA. „S NVIDIA H200 je špičková end-to-end AI superpočítačová platforma právě rychlejší, aby vyřešila některé z nejdůležitějších světových výzev.“

Nvidia uvádí, že H200 bude k dispozici "u globálních výrobců systémů a poskytovatelů cloudových služeb" od 2. čtvrtletí 2024. Řešení nabídnou firmy ASRock Rack , ASUS , Dell Technologies, Eviden, GIGABYTE , Hewlett Packard Enterprise, Ingrasys , Lenovo, QCT , Supermicro, Wistron a Wiwynn.

Zdroj: Nvidia